AI 工具組常見問題集

模型

如何找到我的遠端模型端點和驗證標頭?

這裡有一些範例,說明如何在常見的 OpenAI 服務提供者中找到您的端點和驗證標頭。對於其他提供者,您可以查看他們的 Chat Completion 端點和驗證標頭相關文件。

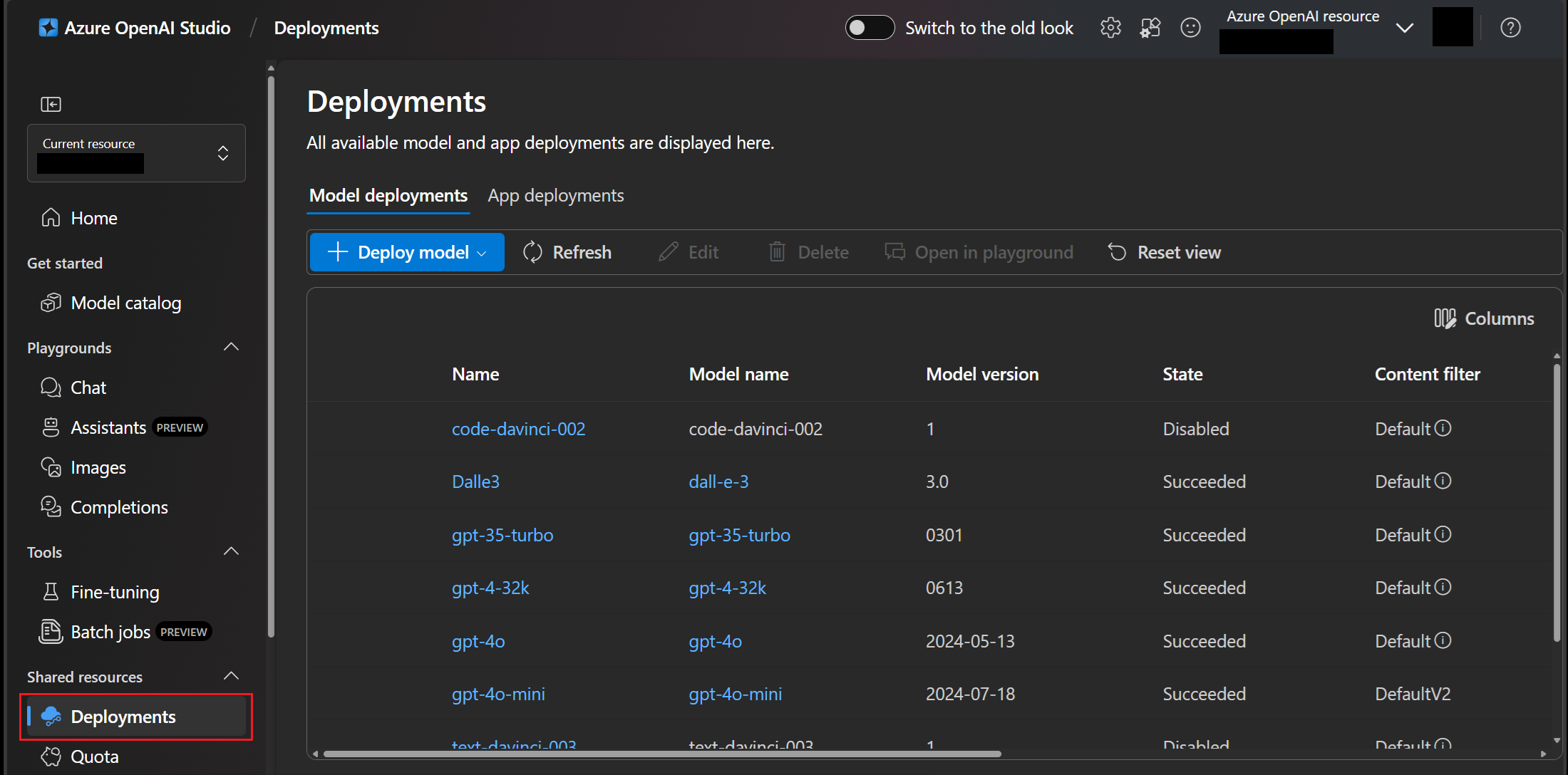

範例 1:Azure OpenAI

-

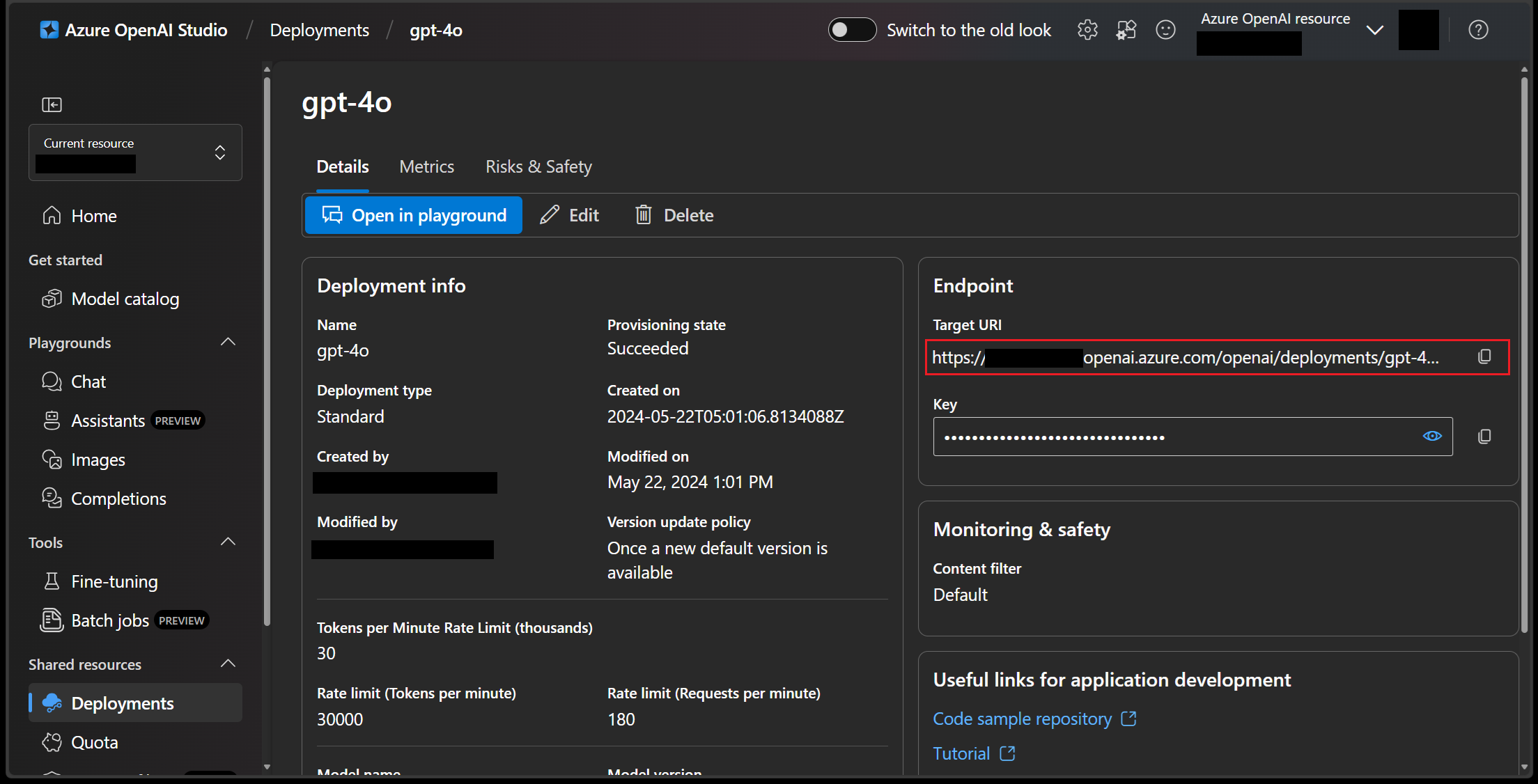

前往 Azure OpenAI Studio 的 [部署] 刀鋒視窗,然後選取一個部署,例如 gpt-4o。如果您還沒有部署,請查看 Azure OpenAI 文件,了解如何建立部署。

-

在 [端點] 區段的 [目標 URI] 欄位中,擷取您的 Chat Completion 端點。

-

從 [端點] 區段的 [金鑰] 屬性取得 API 金鑰。

複製 API 金鑰後,以 api-key: <YOUR_API_KEY> 格式將其新增至 AI Toolkit 中的驗證標頭。請參閱 Azure OpenAI 服務文件,以深入了解驗證標頭。

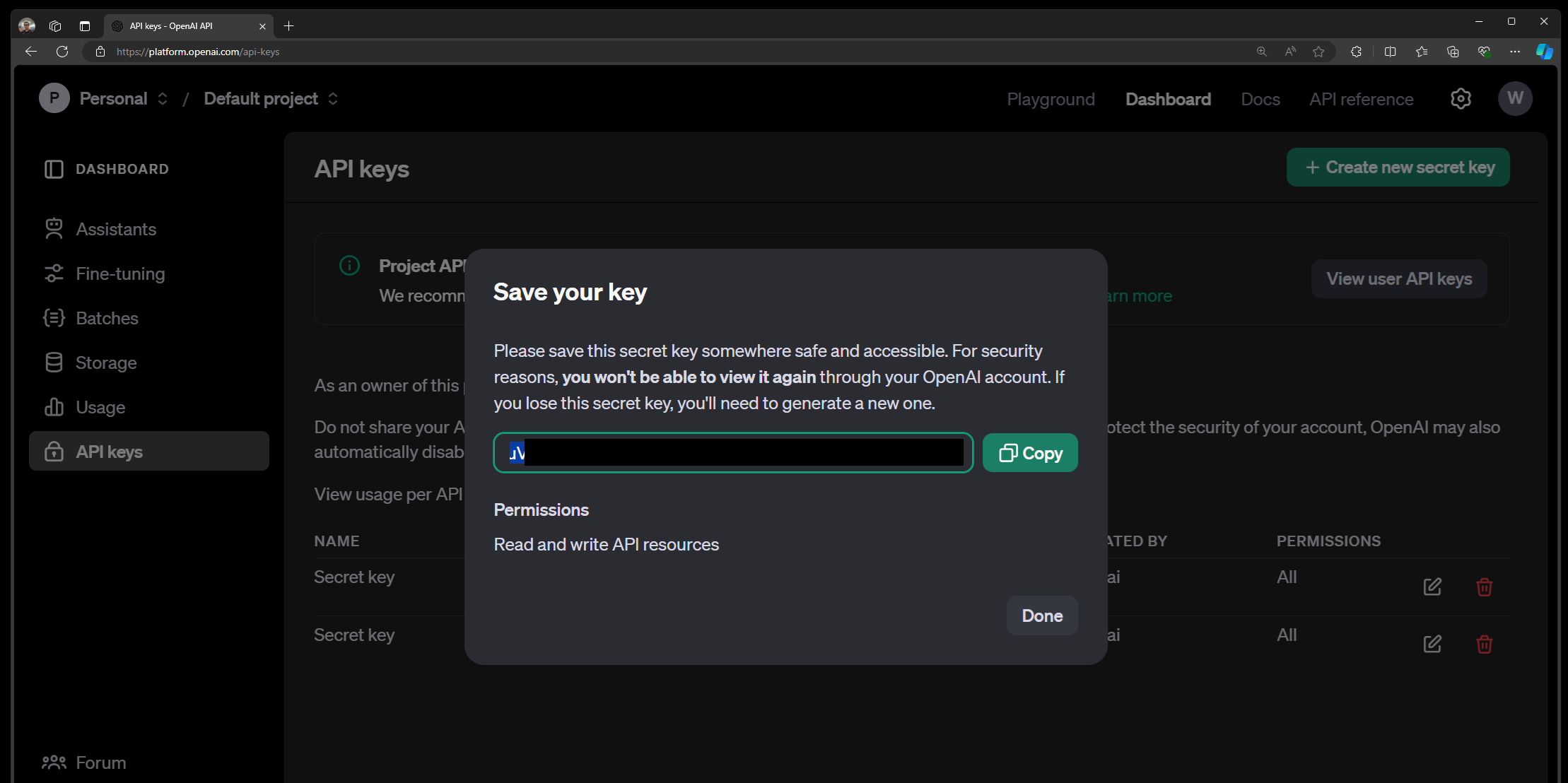

範例 2:OpenAI

-

目前,Chat Completion 端點固定在

https://api.openai.com/v1/chat/completions。請參閱 OpenAI 文件以深入了解。 -

前往 OpenAI 文件,然後選取 [API 金鑰] 或 [專案 API 金鑰] 以建立或擷取您的 API 金鑰。

複製 API 金鑰後,以 Authorization: Bearer <YOUR_API_KEY> 格式填入 AI Toolkit 中的驗證標頭。請參閱 OpenAI 文件以取得更多資訊。

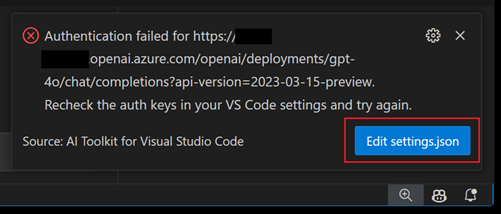

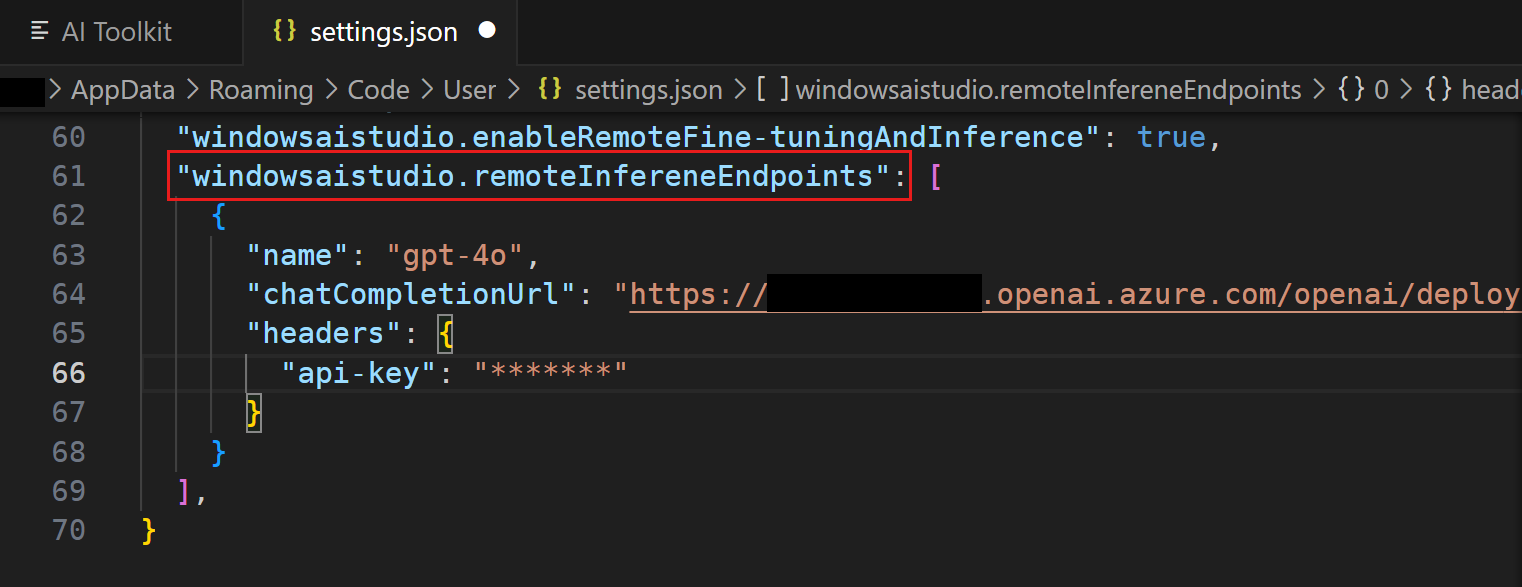

如何編輯端點 URL 或驗證標頭?

如果您輸入錯誤的端點或驗證標頭,可能會在推斷時遇到錯誤。

-

開啟 VS Code 的 setting.json 檔案

-

在驗證失敗通知中選取 [編輯 settings.json]

-

或者,在命令選擇區中輸入「Open User Settings (JSON)」(⇧⌘P (Windows、Linux Ctrl+Shift+P))

-

-

搜尋 windowsaistudio.remoteInfereneEndpoints 設定

-

編輯或移除現有的端點 URL 或驗證標頭。

儲存設定後,樹狀檢視或實驗場中的模型清單將自動重新整理。

如何加入 OpenAI o1-mini 或 OpenAI o1-preview 的等候名單?

OpenAI o1 系列模型專為處理推理和解決問題任務而設計,具有更高的專注力和能力。這些模型花費更多時間處理和理解使用者的要求,使其在科學、程式碼撰寫、數學和類似領域中特別強大。例如,醫療保健研究人員可以使用 o1 來註解細胞定序資料,物理學家可以使用 o1 來產生量子光學所需之複雜的數學公式,以及各領域的開發人員可以使用 o1 來建置和執行多步驟工作流程。

o1-preview 模型僅限於有限存取。若要在實驗場中試用模型,需要註冊,且會根據 Microsoft 的資格標準授予存取權。

造訪 GitHub 模型市集以尋找 OpenAI o1-mini 或 OpenAI o1-preview,並加入等候名單。

我可以使用自己的模型或 Hugging Face 的其他模型嗎?

如果您自己的模型支援 OpenAI API 合約,您可以將其託管在雲端,並將模型新增至 AI Toolkit 作為自訂模型。您需要提供金鑰資訊,例如模型端點 URL、存取金鑰和模型名稱。

微調

有許多微調設定。我需要擔心所有這些設定嗎?

不用,您可以使用預設設定和我們的範例資料集進行測試。您也可以選取自己的資料集,但您需要調整一些設定。請參閱微調教學課程以取得更多資訊。

AI Toolkit 未搭建微調專案

安裝擴充功能之前,請務必檢查擴充功能必要條件。

我有 NVIDIA GPU 裝置,但必要條件檢查失敗

如果您有 NVIDIA GPU 裝置,但必要條件檢查失敗並顯示「未偵測到 GPU」,請確定已安裝最新的驅動程式。您可以在 NVIDIA 網站檢查和下載驅動程式。

此外,請確定它已安裝在路徑中。若要驗證,請從命令列執行 nvidia-smi。

我已產生專案,但 Conda activate 無法找到環境

設定環境時可能發生問題。您可以從工作區內使用 bash /mnt/[PROJECT_PATH]/setup/first_time_setup.sh 手動初始化環境。

使用 Hugging Face 資料集時,我該如何取得?

在您啟動 python finetuning/invoke_olive.py 命令之前,請確定您已執行 huggingface-cli login 命令。這可確保資料集可以代表您下載。

環境

擴充功能是否可在 Linux 或其他系統中運作?

是的,AI Toolkit 可在 Windows、Mac 和 Linux 上執行。

如何從我的 WSL 停用 Conda 自動啟動

若要停用 WSL 中的 Conda 安裝,請執行 conda config --set auto_activate_base false。這會停用基礎環境。

您今天支援容器嗎?

我們目前正在開發容器支援,並將在未來版本中啟用。

為什麼您需要 GitHub 和 Hugging Face 認證?

我們將所有專案範本託管在 GitHub 中,而基礎模型則託管在 Azure 或 Hugging Face 中。這些環境需要帳戶才能從 API 取得存取權。

我在下載 Llama2 時發生錯誤

請確保您透過 Llama 2 註冊頁面要求存取 Llama。這是為了符合 Meta 的貿易合規性所需。

我無法在 WSL 執行個體內儲存專案

因為在執行 AI Toolkit 動作時目前不支援遠端工作階段,所以當您連線到 WSL 時,無法儲存專案。若要關閉遠端連線,請選取畫面左下角的「WSL」,然後選擇「關閉遠端連線」。

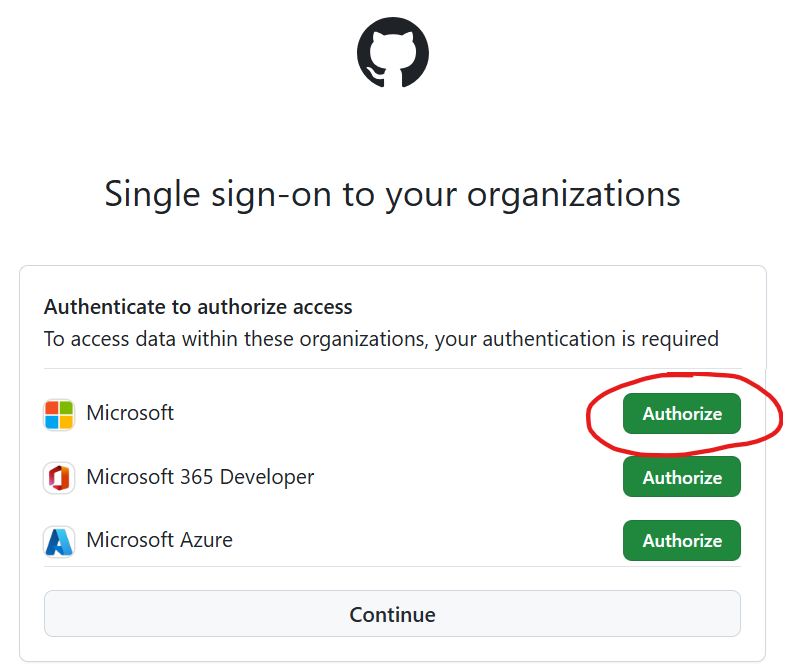

錯誤:GitHub API 禁止存取

我們將專案範本託管在 microsoft/windows-ai-studio-templates GitHub 存放庫中,而擴充功能會使用 GitHub API 來載入存放庫內容。如果您在 Microsoft 內部,可能需要授權 Microsoft 組織,以避免此禁止存取問題。

請參閱此問題以取得解決方案。詳細步驟如下

-

從 VS Code 登出 GitHub 帳戶

-

重新載入 VS Code 和 AI Toolkit,系統會要求您再次登入 GitHub

-

重要事項:在瀏覽器的授權頁面中,請務必授權應用程式存取 Microsoft 組織

無法列出、載入或下載 ONNX 模型

檢查 VS Code 輸出面板中的 AI Toolkit 記錄。如果您看到 Agent 錯誤或「無法取得已下載的模型」,請關閉所有 VS Code 執行個體並重新開啟 VS Code。

(此問題是由於基礎 ONNX 代理程式意外關閉所造成,而上述步驟是為了重新啟動代理程式。)